MNN Chat是一款Android端AI应用,专为在手机上运行大型AI模型而设计。支持文本、图像和语音等多种交互方式,使得用户可以与AI进行更丰富的对话。内置了10多个顶尖的AI模型,如Qwen3和Gemma,满足不同用户的需求。支持文本、图像双模态输入。例如,用户拍摄照片后可直接询问图片内容,系统通过内置的Transformer网络进行识别与反馈。

1、首先需要在本页面下载安装该软件,点击图标打开后使用。

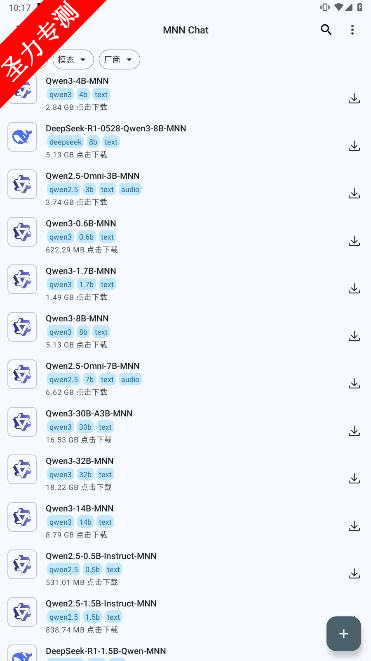

2、进入软件可以看到很多人工智能模型,选择想要使用的模型,点击后面的下载图标。

3、等待下载完成后即可开始使用。

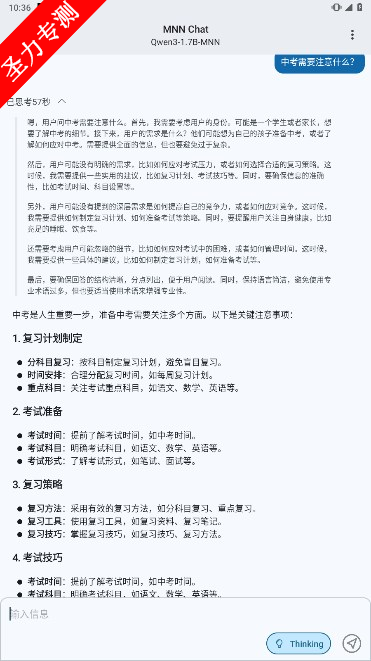

4、点击对话框可以输入内容进行发送。

5、发送完成后,等待一会便可获得其回答。

MNN Chat是一款开源多模态AI聊天软件,基于深度学习推理框架MNN优化部署,可在移动端实现复杂模型的本地化运行。下载模型后,可在手机端独立运行AI推理,无需依赖云端服务器,避免数据上传风险,确保隐私安全。所有交互数据均存储在本地,适合医疗咨询、金融信息处理等对数据保密要求较高的场景。

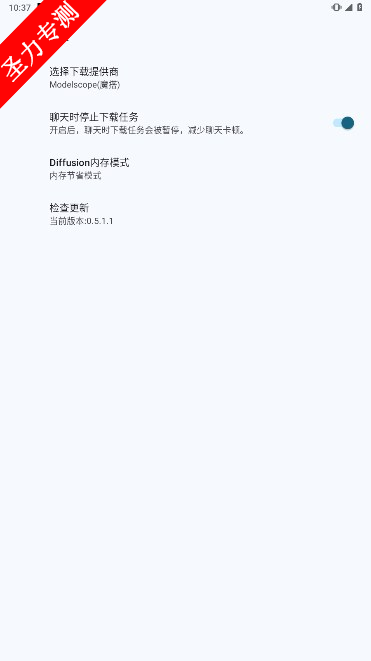

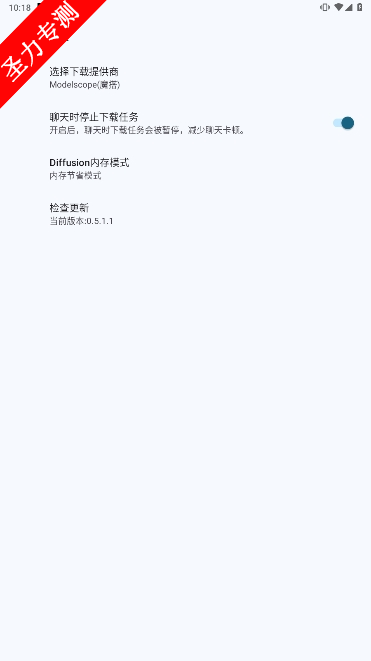

进入软件首页:

打开软件后,进入首页界面,可以看到多种人工智能模型列表。

选择模型:

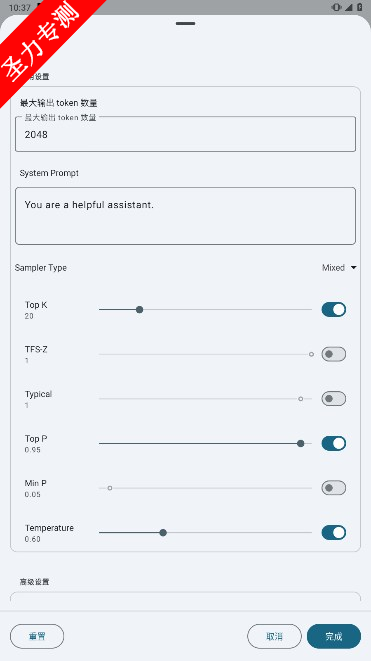

根据需求选择想要使用的模型(如文本生成、对话、翻译等)。

点击模型后面的下载图标。

等待下载完成:

下载时间取决于模型大小和网络速度,请耐心等待。

进入对话界面:

下载完成后,点击已下载的模型,进入对话界面。

输入内容:

点击对话框,输入想要提问或请求的内容。

发送内容:

输入完成后,点击发送按钮。

本地化运营和隐私保护

下载模型后,用户可以在移动设备上独立运行AI推理,而无需依赖云,从而避免数据上传风险。所有交互数据都存储在本地,充分保护用户隐私。

多模式交互支持

支持文本和图像的双模输入。例如,拍照后,用户可以直接查询图像内容,系统通过内置的Transformer网络识别并提供反馈。该功能在电子商务购物指导、教育辅助等场景中具有重要应用价值。

模型兼容性和优化

与TensorFlow、Caffe、ONNX等主流模型格式兼容,涵盖CNN和RNN等网络结构。支持将Qianwen和Baichuan等主流语言模型压缩到移动设备上。例如,在配备LLAMA模型的场景中,原始模型约为15GB,量化后只需要3.8GB即可运行,推理精度损失控制在3%以内。

轻量化设计和高效性能

通过使用FP16半精度浮点和Int8整数量化技术,模型体积可以减少50%-75%。通过深度优化CPU指令集和GPU加速(支持华为HIAI和安卓NNAPI),中低端设备也可以实现二级响应。测试数据显示,配备Snapdragon 7系列处理器的手机在运行文本生成任务时的平均延迟不到1.2秒。

有数计算3d缩水软件下载v1.1.0 手机版

辅助工具 / 15.5M / 2025-07-21

辅助工具 / 15.5M / 2025-07-21

taptap官方下载安装最新版v2.84.6 手机版

辅助工具 / 27.1M / 2025-07-18

辅助工具 / 27.1M / 2025-07-18

PUBGToolPro助手画质助手官方正版v1.2.4 安卓版

辅助工具 / 16.1M / 2025-07-17

辅助工具 / 16.1M / 2025-07-17

OGM折相思游戏盒子下载v3.1.0 安卓版

辅助工具 / 33.3M / 2025-07-16

辅助工具 / 33.3M / 2025-07-16

金砖弱网4.0下载免费参数版v4.0 安卓版

辅助工具 / 213.8M / 2025-07-16

辅助工具 / 213.8M / 2025-07-16

汉克米应用商店最新版下载v25.5.13 官方版

辅助工具 / 4.0M / 2025-07-16

辅助工具 / 4.0M / 2025-07-16